On m’a récemment partagé un article de La Presse intitulé : Pourquoi Google est en train de saborder le web.

Titre qui traduit, déjà, la panique de son auteur ! Et oui, le web évolue.

Et vous aurez toujours face à vous deux discours. Les rares spécialistes qui sont dedans depuis longtemps (plus de 15 ans), ont tout un historique à leur actif de changements — qui pourraient sembler moins importants que la menace IA… et pourtant. Pourquoi s’attacher à l’ancien ?

Je ne comprends pas les pessimistes de mauvaise augure. Rien que ce passage est bien contradictoire : « Google va répondre à notre place… » . Voila pourquoi cela fait quelques mois que nous travaillons sur le référencement IA & GEO, dans les LLMs.

Mais qui répondait aux questions des internautes avant ? Des sites de niche truffés de pop-ups, de mauvaises pratiques UX et d’articles vides rédigés pour le référencement ? Combien de prospects ont décliné nos offres de services, en prétextant que la corrélation Backlinks et Leads n’était pas évidente ? Ou avec l’optimisation de contenu, les extraits enrichis ? Le contenu profond ?

Eh bien voilà.

Une évolution de l’offsite et des rich snippets

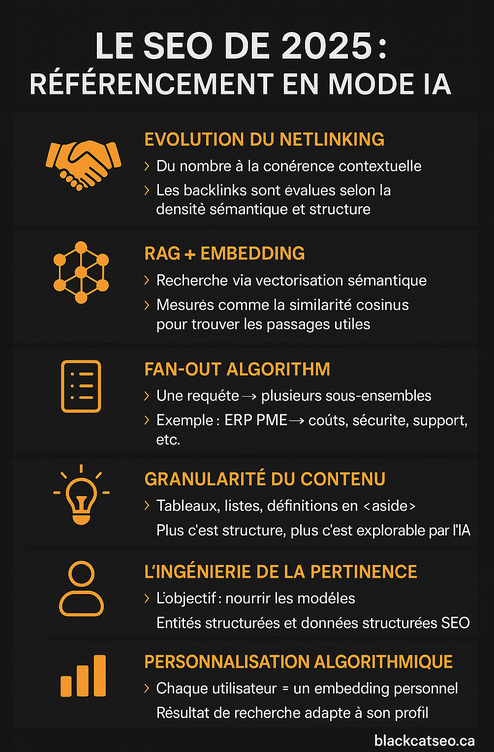

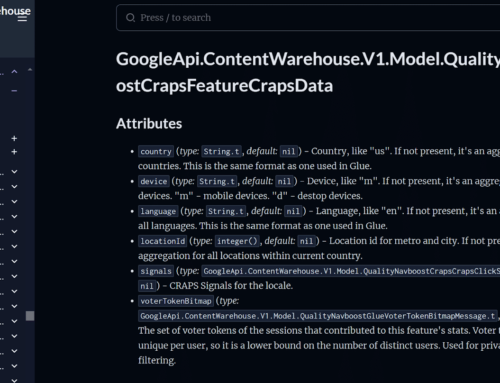

Aujourd’hui, tout devient plus clair : l’IA favorise la qualité. Il fallait investir dans une stratégie de backlinks robuste, issue de domaines de confiance, dans des contextes éditoriaux solides. L’époque des annuaires douteux, des PBN opaques et des échanges de liens artificiels est révolue. Les moteurs IA, en particulier ceux intégrés aux modèles comme Gemini, évaluent non seulement la présence d’un lien, mais aussi la cohérence contextuelle, la densité sémantique locale, et même la structuration du code HTML autour du lien.

Cela signifie que le netlinking n’est plus simplement quantitatif ou basé sur le Domain Authority : il repose désormais sur des métriques de vectorisation sémantique du voisinage textuel. En clair : un backlink qui entoure des entités nommées, des mots-clés contextuellement pertinents et une logique argumentative forte aura bien plus de poids qu’un lien isolé dans un footer générique.

Les extraits enrichis (rich snippets) ne sont pas non plus morts : ils deviennent des unités de contenu que Google peut réutiliser comme passages dans sa synthèse IA. Un tableau bien structuré en HTML, un comparatif clair dans une balise <section>, ou une définition en <aside> : tout cela est désormais exploité en fragments modulaires, encodés, scorés puis rangés dans une base vectorielle interne accessible par Gemini.

Cette approche se traduit déjà dans la manière dont les moteurs IA interprètent les requêtes : ils ne listent plus simplement des liens, mais structurent des résultats autour des entités, des intentions et des sources les plus pertinentes, comme on peut le constater dans l’exemple suivant.

[ { "query": "Antonin Pasquereau", "results": [ { "index": "1.1", "topic": "LinkedIn / profil", "snippet": "Antonin Pasquereau – Founder – Référencement BlackCat SEO", "source_title": "Antonin Pasquereau - Founder - Référencement BlackCat SEO", "url": "https://ca.linkedin.com/in/antoninpasquereau", "publication_time": "", "byline_age": "", "links": { "LinkedIn": "https://ca.linkedin.com/in/antoninpasquereau" } }, { "index": "1.2", "topic": "IMDb / biographie", "snippet": "After a business school in France, Antonin Pasquereau founded BlackCatSEO Inc.", "source_title": "Antonin Pasquereau - IMDb", "url": "https://www.imdb.com/name/nm13231653/", "publication_time": "", "byline_age": "", "links": { "IMDb": "https://www.imdb.com/name/nm13231653/" } } ] } ]

Interprétation rapide

Query « Antonin Pasquereau »

- Fingerprint LinkedIn : fondateur de BlackCat SEO, profil professionnel visible com+15ca.linkedin.com+15blackcatseo.ca+15

- IMDb : mentionne une formation en école de commerce en France et la création de BlackCatSEO Inc. ca+5imdb.com+5ekom.ca+5

- Interview (SuperbCrew) : expose son parcours et vision autour de l’agence

Query « blackcatseo.ca »

- Site officiel : agence SEO basée à Montréal, spécialisée en SEO, web design, SEM, IA

- Page équipe : confirme qu’Antonin, français diplômé, est responsable du SEO technique au sein de l’équipe

- Blog & outils IA : ils proposent des services avancés en AEO/omr pour IA et moteurs de réponses

Google AI Mode : une autre manière de chercher

Attention, la suite pourrait vous casser un peu la tête.

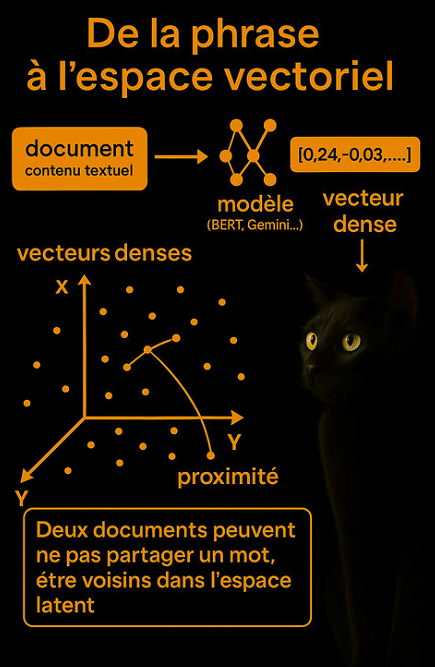

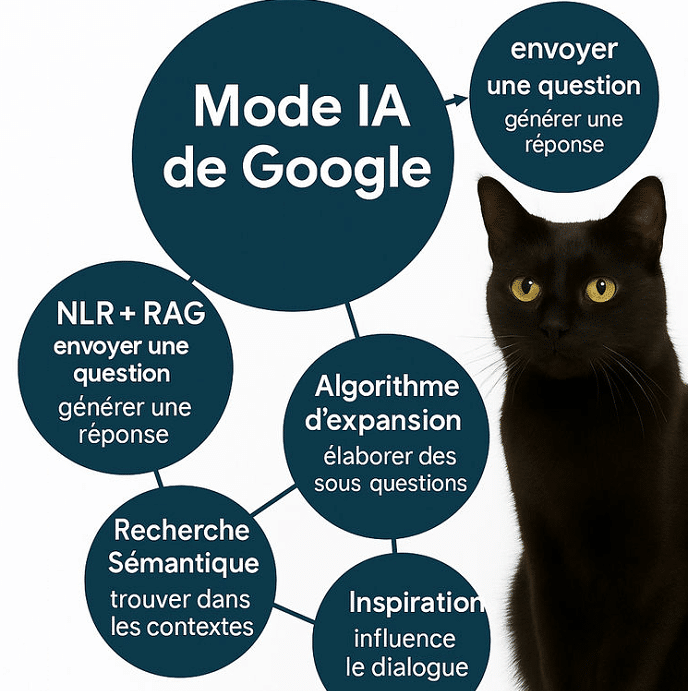

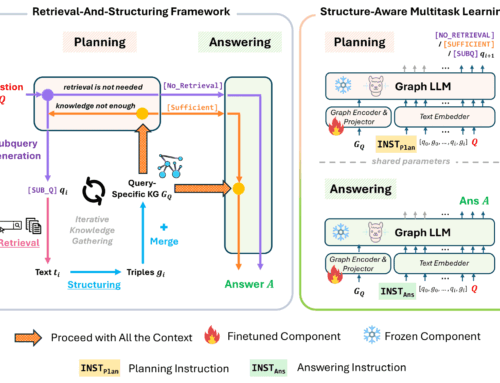

L’AI Mode change radicalement le comportement de Google. On assiste à une transition du modèle IR traditionnel (Information Retrieval) vers un modèle NLR + RAG (Natural Language Retrieval + Retrieval-Augmented Generation). Dans ce paradigme, l’utilisateur envoie une question.

Elle est vectorisée dans un embedding dense (souvent 768 à 2048 dimensions), enrichie par ses données historiques et confrontée à une base d’index déjà vectorisée à l’aide de réseaux neuronaux profonds (notamment BERT, T5 ou Gemini Encoder).

Pour l’instant, nouveaux concepts, nouveaux acronymes, mais surtout, nouvelle logique !

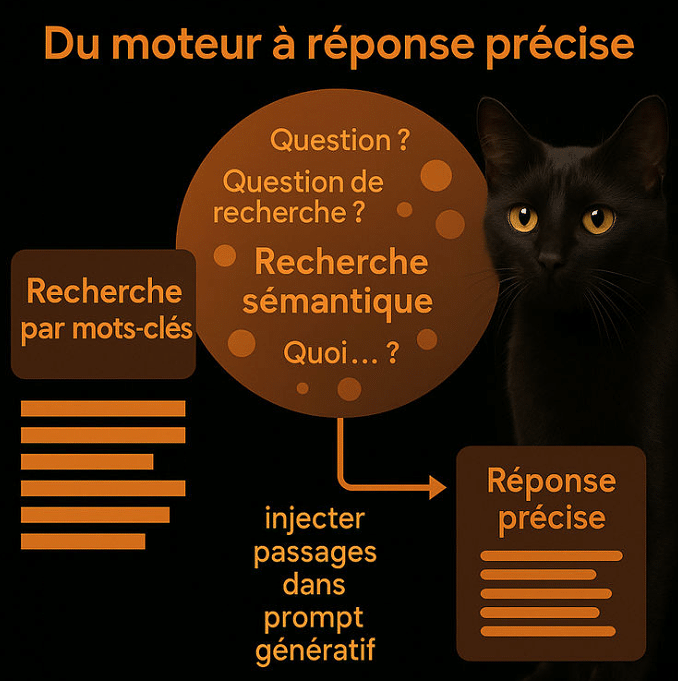

Le moteur ne cherche plus le mot-clé, mais la proximité sémantique dans l’espace latent. Cette similarité est souvent mesurée par des fonctions comme la cosine similarity ou des kernels de type dot-product optimisé. Ce qui en ressort est une liste de documents — ou plutôt de passages — sélectionnés pour leur capacité à répondre à la question.

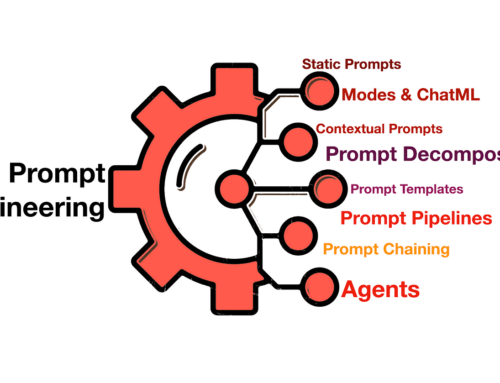

Ces passages sont ensuite injectés dans le prompt du modèle génératif Gemini ou Gemini 1.5 Pro, avec plusieurs niveaux de prompt engineering : réécriture de la question, validation du contexte, exclusion des doublons, etc. Le résultat ? Une synthèse raisonnée inter-source, filtrée et mise en forme selon l’historique de l’utilisateur.

L’algorithme Fan-Out, central à ce système, simule plusieurs sous-questions dérivées de la requête initiale.

Une question comme « Meilleur ERP pour une PME » déclenchera automatiquement des recherches sur : fonctionnalités clés, coûts, intégration, sécurité, support technique, etc. Cette explosion vectorielle de requêtes (Fan-Out Embedding Expansion) alimente une chaîne de raisonnement automatique, souvent implémentée via un Directed Acyclic Graph (DAG) de prompts imbriqués.

Un SEO dépassé par la technologie

TF-IDF ? BM25 ? Ces algorithmes sont des reliques.

L’algo est mort, vive la recherche dense.

Car, le passage à la recherche dense a bouleversé les fondamentaux. Dans le cadre du Google AI Mode, les documents sont représentés comme des vecteurs dans un espace euclidien de plusieurs centaines de dimensions. Cette vectorisation est réalisée à l’aide de modèles de type BERT, Universal Sentence Encoder, ou des encoders maison (Gemini Text Embedder).

Chaque requête utilisateur est également vectorisée, à travers une fonction d’encodage fine-tunée, parfois via Multi-Query Attention (comme dans ColBERT) pour capter l’intention implicite. L’optimisation SEO ne peut donc plus se baser uniquement sur l’alignement lexical : elle doit viser un alignement sémantique profond, mesuré dynamiquement.

Autrement dit, un texte optimisé IA est un texte qui anticipe la manière dont une machine encode le langage, et non dont un humain le lit. Cela impose une refonte complète des stratégies rédactionnelles.

L’ère de l’ingénierie de la pertinence

L’ingénieur de la pertinence ne rédige pas. Il construit des matrices de sens. Son outil principal n’est pas un CMS, mais un graphe conceptuel ou un outil de type Diffbot Knowledge Graph. Il travaille en amont de la production, en organisant l’information selon une logique modulaire et entitaire.

Un bon passage, dans le contexte d’un LLM, répond à trois contraintes :

- Il doit exposer clairement une donnée (fait, date, chiffre)

- Il doit citer des entités uniques (nom d’entreprise, produit, pays)

- Il doit être structuré dans un format identifiable par le modèle (tableau, liste, encadré, définition)

La variété des formats est cruciale : une IA multimodale comme Gemini traite aussi bien les bullet points, que les schémas SVG, les infographies ou les résumés vidéo. C’est une logique d’accessibilité vectorielle : un concept exprimé via plusieurs modalités sera plus facilement repérable et réutilisable.

Exemple d’instruction dans AI Mode

Prenons une requête simple : « Quelles sont les dernières actualités aujourd’hui ? »

Le système ne se contente pas de la traiter directement. Il reformule implicitement cette question en une série de requêtes secondaires. Voici un exemple simulé de requête générée :

print(google_search.search(queries=[« breaking news », « top stories june 12 », « headlines today », « relevant political updates », « market movements june 12 »]))

Chaque requête produit un résultat, ou plutôt une liste de passages pertinents, extraits en temps réel via la bibliothèque interne tool_code. Ces appels sont pilotés par des fonctions internes comme GoogleSearch.SearchResults et GoogleSearch.PerQueryResult, qui structurent et organisent les résultats récupérés dans un index vectoriel. Lorsqu’une réponse nécessite également du contexte conversationnel, Gemini mobilise la fonction ConversationRetrieval.RetrieveConversationsResult pour compléter son raisonnement à partir de l’historique pertinent.

L’ensemble des passages ainsi obtenus est injecté comme context window dans la réponse synthétique de Gemini. Ce mécanisme, proche du document chunking + retrieval, est le cœur de la génération d’AI Mode.

Dans ce contexte, la granularité des documents importe : plus un site propose des unités de contenu discrètes, bien balisées et thématiquement cohérentes, plus il est probable que certains passages soient extraits comme candidats.

Comment AI Mode sélectionne les snippets ?

Google utilise une architecture hybride : d’abord un préfiltrage basé sur importance structurelle (balises HTML, position dans le DOM, lisibilité), suivi d’un re-encodage des passages candidats, puis d’un scoring basé sur cosine similarity, attention contextuelle, et parfois contrôle qualité via RLHF.

Voici un tableau comparatif des critères d’inclusion d’un passage dans Gemini AI Mode :

| Critère | Impact sur la sélection | Exemple |

| Présence d’entités nommées | Très fort | « Microsoft a lancé Azure AI en 2023 » |

| Format structuré (tableau, liste, aside) | Fort | <table><tr><td>ERP</td><td>Prix</td> |

| Proximité vectorielle avec la requête | Essentiel | cosine_similarity > 0.82 |

| Cohérence intra-passage | Modéré | Passage sans rupture thématique |

| Historique de performance | Variable | Passage déjà cliqué ou validé par RLHF |

Personnalisation algorithmique : chaque recherche est unique

L’utilisateur n’est plus une session anonyme : il devient un embedding utilisateur. Ce vecteur de profil est calculé via ses requêtes, clics, favoris, historique Gmail, Maps, YouTube. Ce vecteur influence :

- la reformulation de la requête

- la priorisation des documents

- la mise en forme de la réponse (ton, longueur, format)

Cela signifie que deux personnes, à une seconde d’intervalle, obtiendront deux réponses AI Mode différentes pour la même requête. Le SEO devient une stratégie de présence dans les univers vectoriels individuels. Pour les marques, cela suppose non seulement d’occuper le territoire sémantique général, mais aussi de multiplier les points de contact avec des formats adaptés aux profils types (courts, techniques, vulgarisés, infographiques, etc.).

Vers une stratégie de marque sémantique

L’entreprise moderne doit penser sa présence non pas comme une série de positions dans Google, mais comme une présence algorithmique dans l’espace sémantique. Cela implique d’intégrer sa marque dans les structures cognitives du modèle : mentions répétées dans des contextes qualitatifs, co-occurrence avec des entités thématiques majeures, intégration dans des documents bien notés par les modèles.

Cela nécessite aussi une refonte des indicateurs traditionnels. On parlera non plus seulement de visibilité organique, mais de :

- Fréquence d’apparition dans les réponses générées (tracking SGE)

- Part de voix vectorielle (alignement entre embedding de marque et ceux des requêtes marché)

- Suivi des citations implicites (brand tracking sans lien hypertexte)

On parle ici d’une PR algorithmique : influencer les modèles, pas les journalistes. Et cela demande un travail de fond, sur le contenu, le format, le linking et surtout la régularité dans la structuration des signaux entitaires.

Méthodologie : comment mesurer sa visibilité AI Mode ?

La mesure devient expérimentale. Quelques pratiques recommandées :

- Requête testée depuis plusieurs profils (incognito, compte Gmail actif, device Android)

- Observation des passages utilisés dans AI Mode (via export SGE ou analyse des logs)

- Analyse sémantique avec LangChain, Haystack, RAGStack ou Vertex AI Search

- Scoring vectoriel avec SentenceTransformer (paraphrase-mpnet-base-v2) ou Gemini Embedding API

Des outils de type PromptLayer, Traceloop ou même des frameworks comme LlamaIndex peuvent aider à comprendre comment une requête est transmise au modèle, quels documents sont sollicités, et quels paramètres influencent la formulation finale.

Un bon indicateur reste l’empreinte sémantique : le nombre de fois où un domaine est mobilisé, dans des requêtes diverses, à travers plusieurs formats de réponse (tableau, citation, résumé, schéma).

Et donc – modéliser plutôt que manipuler

Google ne détruit pas le web. Il le recompose sous forme vectorielle. Le défi est immense, mais l’opportunité l’est encore plus. Pour ceux qui comprendront que rédiger ne suffit plus, qu’il faut structurer, vectoriser, modéliser.

Le SEO d’aujourd’hui est un jeu à plusieurs niveaux : contenu, architecture, PR, prompt engineering… mais surtout compréhension des modèles. C’est une guerre de couches, de formats, de signaux entitaires, et de granularité.

La meilleure stratégie n’est plus de manipuler l’algorithme, mais de lui faciliter le raisonnement. En nourrissant ses couches intermédiaires, en balisant le terrain pour qu’il vous sélectionne naturellement, sans forcing ni triche.

Le plus grand danger n’est pas l’IA. C’est de continuer à faire du SEO comme si nous étions en 2015.

Ecrire un commentaire